Atténuation des reflets et des ombres¶

Le téléphone étant posé sur un support tout au long de la résolution, les photos sont toutes prises dans un même environnement. Ainsi, les reflets et les ombres perçues sur l'écran sont toujours les mêmes et entraînent toujours des dégradations aux mêmes endroits. Le but de ce traitement était donc de reconnaître ces dégradations afin de les supprimer et ainsi reconstituer une image plus nette et plus propre. Pour cela le téléphone doit prendre deux photos différentes, une première photographie d'un écran noir et une seconde d'un écran blanc. D'un point de vue théorique, si la photo était parfaite, sans aucune dégradation, les couleurs obtenu serait totalement identiques à ce qu'affiche l'écran. Autrement dit, la photo sans dégradation devrait être composé uniquement de pixels noir ayant pour valeur RGB 0,0,0 ou bien totalement composé de pixels blanc avec pour valeur RGB 255,255,255. Ainsi chaque différence obtenue sur une photo réel correspond à l'impact de la dégradation. Si un pixel de la photo possède les composantes RGB 15,13,4 cela signifie que la dégradation au niveau de ce pixel augmente de 15,13 et 4. Pour supprimer cette dégradation correspondant à un reflet, il suffit de soustraire l'image que l'on veut traiter par l'image de l'écran noir.

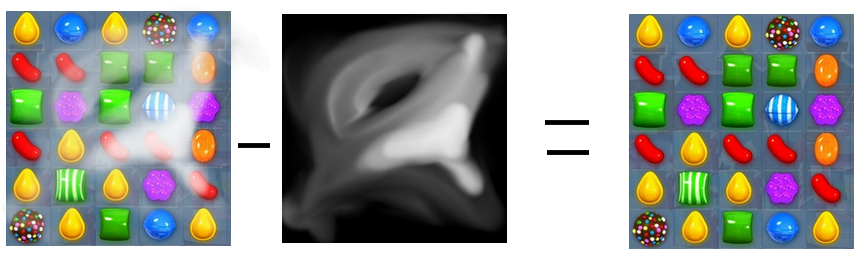

Figure n°26 : Suppression d'un reflet depuis une image noir

Le traitement de l'ombre repose globalement sur le même principe. Nous prenons en photo un écran totalement blanc composé uniquement de pixels au composantes 255,255,255. Puis nous obtenons une image d'un écran blanc avec quelques ombres représentées par des pixels grisés. Pour supprimer cette ombre de l'image il faut diviser chaque composante par la valeur obtenue sur l'image de l'écran blanc puis la multiplier par 255. Ainsi, on réajuste les couleurs de l'image à traiter en utilisant les valeurs de dégradation observées sur l'image de l'écran blanc.

En effectuant ces deux traitement sur une image cela nous permet d'obtenir une image plus nette et avec des dégradations réduites. Cependant l'utilisation d'un Android pour prendre les photos apportent à cette méthode un obstacle important rendant le traitement inutilisable. En effet bien que le téléphone ne soit pas déplacé, l'environnement est modifié automatiquement lorsque l'écran passe de l'image noir à l'image blanche. Afin de donner des photographies adaptées, la camera du téléphone modifie automatiquement la luminosité de l'image. Ainsi, lorsque l'écran noir est pris en photo, le téléphone détecte un environnement sombre, et augmente la luminosité. A l'inverse lorsque l'on prend un écran blanc, il va détecter un environnement lumineux, et va diminuer la luminosité.

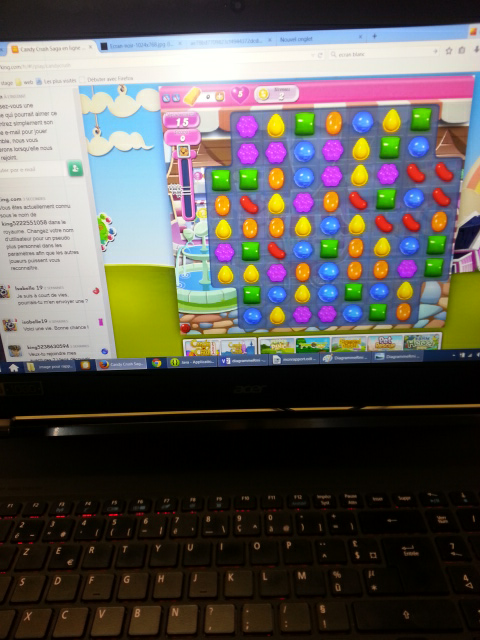

Figure n°27 : Différence de luminosité en fonction du contenu de l'écran

On obtient donc des dégradations bien trop importantes. De plus le changement d'environnement amène à des différences de dégradations entre la prise de photo de l'écran noir et la prise de photo de la grille. On effectue alors des modifications trop importantes sur des pixels étant à la base faiblement touché sur la photo de la grille. Le résultat du traitement donne donc au final une image plus difficile à utiliser et plus dégradée que l'original.

Figure n°28 : Résultat du traitement

Mis à jour par Anonyme il y a environ 10 ans · 5 révisions